Veille Technologique MCP – Semaine 50 2025 : Maturité de l’Écosystème et Adoption Multi-Secteurs

Cette synthèse couvrait la période du 8 décembre au 14 décembre 2025 (semaine 50).

Résumé Exécutif

La semaine 50 de 2025 a révélé un écosystème Model Context Protocol parvenu à maturité technique, six mois après la publication de sa dernière spécification majeure du 18 juin 2025. L’architecture fondée sur JSON-RPC 2.0 s’était consolidée autour de trois composants centraux (Hôte/Client/Serveur), tandis que les implémentations en production démontraient une adoption significative à travers des secteurs diversifiés : automatisation RH, gestion financière, support clinique en santé et intégration ERP.

La documentation technique avait atteint un niveau de complétude remarquable avec des serveurs de référence opérationnels (systèmes de fichiers, intégrations Git, automatisation Puppeteer, connecteurs Slack et APIs tierces). L’écosystème développeur présentait une richesse substantielle avec des tutoriels couvrant cinq langages majeurs (TypeScript, Python, C#, Java, Rust) et des guides d’implémentation documentant des cas d’usage concrets : serveur météo, intégration Hacker News, API Star Wars et connecteur Medium.

Les déploiements d’entreprise confirmaient une pénétration sectorielle étendue, notamment à travers l’intégration AWS avec Amazon Bedrock qui validait l’adoption par les plateformes cloud d’entreprise. Les discussions techniques soulevaient toutefois des défis persistants : complexité de l’authentification, limitations des garanties machine-readable et dépendances à l’ingénierie de prompts.

Évolution et Contexte

Positionnement Temporel

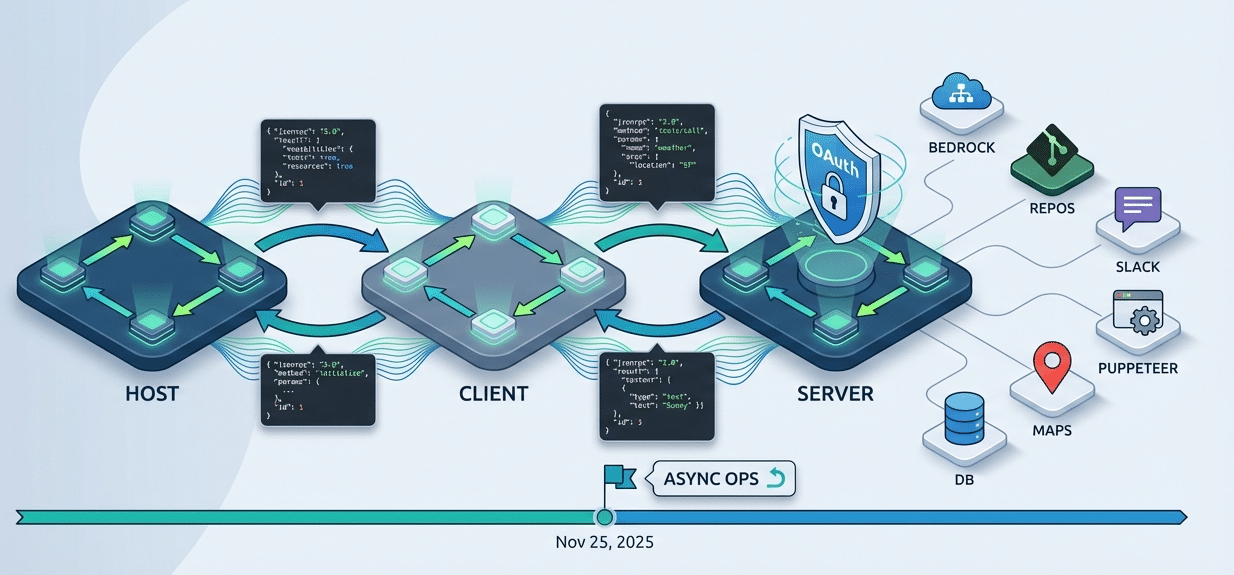

Cette analyse constituait la première semaine formelle de surveillance du Model Context Protocol, établissant ainsi la baseline pour les veilles futures. La période observée se situait six mois après la publication de la dernière spécification majeure (18 juin 2025) et plusieurs semaines après le jalon prévu du 25 novembre 2025 pour les opérations asynchrones.

État de l’Écosystème

L’architecture technique présentait une maturité avancée avec une base JSON-RPC 2.0 éprouvée et trois composants fondamentaux bien définis. Les implémentations en production démontraient une diversification significative à travers des serveurs de référence couvrant les systèmes de fichiers, les intégrations Git, l’automatisation Puppeteer, les connecteurs Slack et les APIs tierces (Google Maps, Brave Search).

L’écosystème développeur révélait une accessibilité remarquable avec des tutoriels pratiques couvrant cinq langages majeurs et des guides d’implémentation documentant des cas d’usage concrets. Cette orientation vers l’accessibilité pour les développeurs débutants témoignait d’une volonté de démocratisation du protocole.

Adoption Entreprise

Les déploiements en entreprise illustraient une pénétration sectorielle étendue : automatisation RH/ATS, gestion financière, support clinique en santé, intégration ERP et IoT/edge computing. L’intégration AWS avec Amazon Bedrock confirmait l’adoption par les plateformes cloud d’entreprise, marquant une transition vers des déploiements à grande échelle.

Défis Identifiés

Les discussions techniques sur Hacker News avaient soulevé des défis d’implémentation structurels : complexité de l’authentification, limitations des garanties machine-readable et dépendances persistantes à l’ingénierie de prompts. Ces obstacles représentaient les axes d’amélioration prioritaires pour l’évolution future du protocole.

Actualités

Architecture et Spécification Technique

La documentation technique avait consolidé une architecture fondée sur JSON-RPC 2.0 avec trois composants centraux clairement définis : Hôte, Client et Serveur. Le protocole implémentait une négociation de capacités sophistiquée permettant aux clients et serveurs de découvrir mutuellement leurs fonctionnalités supportées lors de l’initialisation.

Le système de communication bidirectionnelle s’était structuré autour de schémas de sorties d’outils normalisés, permettant aux serveurs de retourner des données structurées et typées aux LLMs. Les abonnements en temps réel offraient des mécanismes de notification push pour les changements de ressources, tandis que les capacités d’échantillonnage permettaient aux serveurs d’initier des appels LLM via le client.

La feuille de route identifiait les opérations asynchrones comme priorité majeure pour le jalon du 25 novembre 2025, ciblant spécifiquement les tâches à longue durée d’exécution qui nécessitaient une gestion de cycle de vie sophistiquée.

Évolution de la Spécification

La dernière version majeure publiée le 18 juin 2025 avait introduit plusieurs avancées significatives. L’autorisation OAuth permettait désormais une délégation sécurisée des accès pour les intégrations tierces, tandis que les améliorations de sécurité renforçaient les mécanismes de contrôle d’accès et de consentement utilisateur.

Les sorties d’outils structurés constituaient une évolution majeure, remplaçant les réponses textuelles non structurées par des schémas JSON typés qui garantissaient une meilleure interopérabilité machine-to-machine et réduisaient les ambiguïtés d’interprétation.

Implémentations en Production

L’écosystème comptait plusieurs serveurs de référence opérationnels démontrant la viabilité du protocole dans des contextes variés. Le serveur Filesystem offrait un accès sécurisé aux fichiers locaux avec contrôles de permissions granulaires. Les intégrations Git/GitHub/GitLab permettaient l’interrogation de dépôts, la lecture de contenu de fichiers et l’analyse d’historique de commits.

Le serveur Puppeteer automatisait les interactions de navigateur pour le scraping web et les tests d’interface, tandis que le connecteur Slack exposait les fonctionnalités de messagerie d’équipe aux agents IA. Les APIs tierces incluaient Google Maps pour les données géographiques et Brave Search pour les requêtes web décentralisées.

L’intégration AWS KB Retrieval connectait les bases de connaissances Amazon Bedrock au protocole, permettant aux applications d’entreprise de tirer parti des capacités de recherche vectorielle et de récupération augmentée de génération (RAG) des services cloud AWS.

Adoption Sectorielle

Les cas d’usage en entreprise documentés couvraient plus de dix secteurs distincts. Dans le domaine des ressources humaines, les systèmes d’automatisation d’agents IA et les intégrations ATS (Applicant Tracking System) rationalisaient les processus de recrutement et d’évaluation de candidats.

Le secteur financier déployait des solutions de gestion des dépenses et d’analyse de risque, utilisant le MCP pour connecter les systèmes comptables aux outils d’aide à la décision alimentés par IA. Les intégrations ERP permettaient aux agents conversationnels d’accéder aux données d’entreprise structurées tout en respectant les politiques de gouvernance.

Dans le domaine de la santé, les systèmes de support décisionnel clinique exploitaient le protocole pour connecter les dossiers patients aux bases de connaissances médicales. Les applications IoT et edge computing utilisaient le MCP pour coordonner les flottes de dispositifs distribués avec des capacités de traitement IA local.

Écosystème Cloud

L’intégration AWS représentait une validation majeure pour l’adoption entreprise du protocole. Les dépôts AWS Labs publiés sur GitHub documentaient les schémas d’intégration avec Amazon Bedrock, incluant les configurations de sécurité, les politiques IAM et les considérations de conformité pour les déploiements réglementés.

Cette intégration démontrait comment les plateformes cloud d’entreprise adoptaient le MCP comme couche de standardisation pour connecter les services managés aux applications IA, réduisant ainsi la complexité d’intégration pour les équipes de développement.

Tutoriels

Curriculum Développeur Multi-Langage

Microsoft avait publié un curriculum open source exhaustif couvrant les fondamentaux du MCP à travers cinq écosystèmes de programmation majeurs : C#, Java, Python, TypeScript et Rust. Ce curriculum structuré incluait les concepts d’architecture de base, les schémas d’implémentation spécifiques à chaque langage et les bonnes pratiques de déploiement.

Les modules C# et Java ciblaient principalement les environnements d’entreprise avec des intégrations .NET et Spring, tandis que les ressources Python et TypeScript se concentraient sur le développement rapide de prototypes. Le contenu Rust adressait les cas d’usage nécessitant des performances maximales et une sécurité mémoire garantie.

Tutoriel Serveur Météo en TypeScript

Un guide étape par étape publié sur Dev.to détaillait la construction d’un serveur MCP connecté à une API météo en direct. Le tutoriel couvrait la configuration initiale du projet avec le SDK TypeScript officiel, l’implémentation des gestionnaires de requêtes JSON-RPC et la définition de schémas d’outils pour exposer les fonctionnalités météo.

La section d’intégration IDE documentait la configuration de VS Code et GitHub Copilot pour tester le serveur directement depuis l’environnement de développement. Les procédures de test incluaient des exemples de requêtes JSON-RPC et les réponses structurées attendues, offrant ainsi un cycle de développement complet accessible aux débutants.

SDK C# avec Visual Studio Code

Un tutoriel focalisé sur l’écosystème .NET démontrait l’implémentation d’un serveur MCP en C# avec intégration VS Code Copilot. L’exemple pratique construisait un outil GetCurrentTime simple mais instructif, illustrant les concepts fondamentaux de déclaration d’outil, de gestion de requêtes et de sérialisation de réponses.

Le guide documentait les schémas d’intégration spécifiques aux environnements d’entreprise .NET, incluant la configuration des dépendances NuGet, la structuration de projets selon les conventions architecturales .NET et les considérations de déploiement pour les contextes Windows Server.

SDK Python avec GitHub

Un exemple concret utilisant MCP CLI et le SDK Python implémentait une fonctionnalité d’assistant code connecté à l’API GitHub. Le tutoriel couvrait la définition de schémas d’outils pour interroger les métadonnées de dépôts, l’implémentation des gestionnaires serveur avec gestion d’erreurs asynchrone et les schémas d’interrogation IA sur les données de dépôt récupérées.

La section d’architecture expliquait comment structurer les serveurs Python pour la maintenabilité à long terme, incluant la séparation des couches transport, logique métier et intégration API. Les bonnes pratiques de sécurité adressaient la gestion des tokens d’API et la validation des entrées utilisateur.

Serveur Hacker News en JavaScript

Un tutoriel technique approfondi construisait un serveur MCP connecté à l’API Hacker News, avec une concentration forte sur la mécanique du protocole JSON-RPC 2.0. L’implémentation couvrait plusieurs couches de transport : stdio pour les environnements CLI et Server-Sent Events (SSE) pour les déploiements web.

Le guide détaillait les schémas d’exposition d’outils pour rechercher des articles, récupérer des commentaires et agréger des statistiques de threads de discussion. La section de débogage documentait les techniques de traçage des messages JSON-RPC et de diagnostic des problèmes de sérialisation.

API Star Wars en TypeScript

Un tutoriel couvrant le cycle de développement complet implémentait un serveur MCP connecté à l’API Star Wars (SWAPI). Au-delà de l’implémentation de base, le guide adressait les considérations de déploiement en production : hébergement sur plateformes serverless, gestion des variables d’environnement, implémentation de l’authentification et conteneurisation Docker.

Les schémas de déploiement documentés incluaient les configurations pour AWS Lambda, Azure Functions et Google Cloud Functions, offrant ainsi une flexibilité pour divers environnements cloud. La section Docker fournissait des Dockerfiles optimisés et des configurations docker-compose pour les déploiements locaux et staging.

Transport stdio en Python

Une analyse technique approfondie du transport stdio expliquait comment construire des serveurs MCP communicant via les flux standard d’entrée/sortie. Ce guide se distinguait par sa concentration sur les détails d’implémentation de la couche transport : buffering des messages, parsing de JSON streaming et gestion des situations d’erreur au niveau protocole.

Les modèles de communication documentés couvraient les schémas de requête-réponse synchrones, les notifications unidirectionnelles et les mécanismes de heartbeat pour la détection de connexions interrompues. Les exemples Python utilisaient les bibliothèques asyncio pour la gestion concurrente des connexions multiples.

Intégration Medium en TypeScript

Une implémentation open source d’un serveur MCP pour l’API Medium démontrait l’interrogation de contenu et l’extraction assistée par IA. Le dépôt documentait les schémas d’authentification OAuth spécifiques à Medium, les endpoints d’API pour récupérer les articles, les brouillons et les statistiques de publication.

L’architecture serveur illustrait comment structurer les intégrations de plateformes de contenu avec des capacités de recherche sémantique, permettant aux agents IA de découvrir des articles pertinents via des requêtes en langage naturel plutôt que des filtres d’API explicites.

Développements Techniques

Discussions Hacker News

Les discussions techniques sur Hacker News avaient produit une analyse approfondie de l’implémentation RPC-over-WebSockets et de ses implications pour les architectures distribuées. Les développeurs débattaient des avantages des contrats JSON-schema par rapport aux définitions de types statiques générées à la compilation, soulignant les compromis entre flexibilité runtime et sécurité de types.

La gestion du cycle de vie des outils constituait un sujet de discussion majeur, particulièrement pour les outils à longue durée d’exécution nécessitant des mécanismes de cancellation, de pause et de reprise. Les participants identifiaient la surcharge du protocole comme préoccupation pour les déploiements à haute fréquence, questionnant l’efficacité de JSON-RPC 2.0 comparé aux alternatives binaires comme gRPC.

Défis d’Implémentation

La complexité de l’authentification émergeait comme défi structurel majeur. Les développeurs rapportaient des difficultés à implémenter des flux OAuth sécurisés pour les serveurs MCP, particulièrement dans les scénarios multi-tenants où les tokens devaient être isolés par utilisateur. Les mécanismes de rafraîchissement de tokens et la gestion des révocations nécessitaient une logique d’orchestration complexe pas entièrement spécifiée dans le protocole de base.

Les limitations des garanties machine-readable constituaient une frustration récurrente. Bien que les schémas JSON définissent les structures de données, les contraintes sémantiques et les règles métier restaient largement documentées dans du texte lisible par les humains. Cette ambiguïté forçait les implémentations à inclure une logique de validation extensive et des tests de conformité manuels.

Les dépendances persistantes à l’ingénierie de prompts représentaient un obstacle à l’interopérabilité totale. Malgré la standardisation du protocole, les différents LLMs interprétaient les descriptions d’outils et les schémas de paramètres avec des niveaux de fidélité variables, nécessitant des ajustements spécifiques par modèle pour des résultats optimaux.

Architecture de Sécurité

La documentation officielle détaillait des mécanismes de consentement sophistiqués pour l’échantillonnage LLM. Lorsque des serveurs initiaient des appels LLM via le client, des workflows de consentement explicite garantissaient que les utilisateurs autorisaient ces opérations potentiellement coûteuses. Les modèles de contrôle d’accès permettaient une gestion granulaire des permissions par outil et par ressource.

Les flux d’autorisation documentés couvraient plusieurs scénarios : authentification utilisateur final via OAuth, authentification service-to-service avec clés API et authentification d’applications de bureau avec tokens locaux. Les bonnes pratiques de sécurité incluaient la rotation régulière des credentials, l’audit des accès et la limitation de scope minimal pour les tokens.

Extension MCP-B

Une extension du protocole dédiée à l’automatisation de navigateur avait émergé, démontrant l’extensibilité du MCP au-delà de la spécification centrale. MCP-B définissait des primitives supplémentaires pour contrôler les navigateurs : navigation, interaction avec les éléments DOM, injection de scripts et capture de screenshots.

Cette extension illustrait comment le protocole de base fournissait une fondation solide sur laquelle des spécialisations verticales pouvaient être construites. Les développeurs d’automatisation web exprimaient un intérêt significatif pour cette extension comme alternative standardisée aux APIs propriétaires de contrôle de navigateur.

Cas d’Usage Productivité

Une étude de cas documentée par un ingénieur senior quantifiait les gains de productivité obtenus via l’automatisation de publication de podcasts. Le serveur MCP personnalisé avait réduit un processus manuel de 45 minutes à une exécution automatisée de 5 minutes, représentant un ROI substantiel pour les flux de travail répétitifs.

Le schéma d’optimisation détaillé couvrait l’orchestration de plusieurs outils : transcription audio avec Whisper, génération de métadonnées avec GPT-4, création de visuels avec DALL-E et publication sur plateformes multiples. Cette coordination multi-outils démontrait la valeur du MCP comme couche d’orchestration pour les workflows IA complexes.

Adoption par les Plateformes

Les discussions communautaires documentaient l’adoption du protocole par les principales plateformes de développement IA. Claude d’Anthropic avait intégré le support MCP nativement, permettant aux utilisateurs de connecter des sources de contexte externes directement depuis l’interface conversationnelle. Les outils OpenAI exploraient des intégrations similaires pour les GPTs personnalisés.

Les éditeurs de code Cursor, Zed et Codeium avaient annoncé des implémentations MCP pour étendre les capacités de leurs assistants IA. Replit intégrait le protocole dans ses agents de développement pour accéder aux ressources de projet. Sourcegraph utilisait le MCP pour connecter ses outils de recherche de code aux interfaces conversationnelles.

Cette adoption large par les plateformes majeures validait le MCP comme standard émergent pour l’interopérabilité des outils IA, créant ainsi un effet de réseau où chaque nouvelle intégration augmentait la valeur pour l’écosystème entier.

Conclusion

La semaine 50 de 2025 avait révélé un écosystème Model Context Protocol atteignant une phase de maturité technique significative. L’architecture fondée sur JSON-RPC 2.0 s’était consolidée avec trois composants centraux clairement définis et des mécanismes de négociation de capacités sophistiqués. Les implémentations en production démontraient une adoption substantielle à travers des secteurs diversifiés, validant ainsi la viabilité du protocole dans des contextes d’entreprise exigeants.

L’écosystème développeur présentait une richesse remarquable avec des tutoriels couvrant cinq langages majeurs et des guides d’implémentation documentant des cas d’usage concrets. Cette orientation vers l’accessibilité témoignait d’une volonté de démocratisation qui positionnait le MCP comme standard émergent pour l’interopérabilité des outils IA.

Les déploiements d’entreprise confirmaient une pénétration sectorielle étendue, de l’automatisation RH à la gestion financière, du support clinique en santé à l’intégration ERP. L’intégration AWS avec Amazon Bedrock marquait une transition vers des déploiements cloud à grande échelle, validant le protocole pour les infrastructures d’entreprise critiques.

Les défis techniques persistants identifiés dans les discussions communautaires définissaient les axes d’amélioration prioritaires : simplification de l’authentification, renforcement des garanties machine-readable et réduction des dépendances à l’ingénierie de prompts. La résolution de ces obstacles déterminerait la trajectoire d’adoption à long terme du protocole.

L’adoption large par les plateformes majeures (Claude, outils OpenAI, Cursor, Zed, Replit, Codeium, Sourcegraph) créait un effet de réseau puissant qui accélérait l’écosystème vers une standardisation de facto. Cette dynamique positionnait le Model Context Protocol comme infrastructure critique pour la prochaine génération d’applications IA, établissant ainsi les fondations d’une interopérabilité cross-plateformes jusqu’alors fragmentée.

Glossaire – Pour Mieux Comprendre

API (Application Programming Interface) : Interface de programmation qui permet à deux logiciels de communiquer entre eux. C’est comme un menu de restaurant qui liste les plats disponibles – l’API liste les fonctionnalités qu’un programme peut demander à un autre.

JSON-RPC 2.0 : Protocole léger d’appel de procédures à distance utilisant le format JSON. C’est une manière standardisée pour un programme de demander à un autre programme distant d’effectuer une action, comme passer un appel téléphonique à un service.

OAuth : Protocole d’autorisation permettant à une application d’accéder aux ressources d’un utilisateur sans connaître son mot de passe. C’est comme donner un badge temporaire à un visiteur plutôt que de lui donner votre clé personnelle.

SDK (Software Development Kit) : Ensemble d’outils, de bibliothèques et de documentation permettant aux développeurs de créer des applications pour une plateforme spécifique. C’est comme une boîte à outils complète avec instructions pour construire quelque chose de précis.

WebSockets : Technologie permettant une communication bidirectionnelle en temps réel entre un client et un serveur. C’est comme avoir une ligne téléphonique ouverte en permanence plutôt que d’envoyer des lettres.

LLM (Large Language Model) : Modèle d’intelligence artificielle entraîné sur d’énormes quantités de texte pour comprendre et générer du langage naturel. Des exemples incluent GPT-4 et Claude.

RAG (Retrieval Augmented Generation) : Technique qui permet à un LLM d’accéder à des documents externes pour améliorer ses réponses. C’est comme permettre à quelqu’un de consulter une bibliothèque avant de répondre à une question.

Transport stdio : Méthode de communication utilisant les flux standard d’entrée et de sortie d’un programme. C’est comme communiquer en écrivant sur la console plutôt qu’en utilisant le réseau.

Server-Sent Events (SSE) : Technologie permettant à un serveur d’envoyer des mises à jour automatiques vers un client. C’est comme recevoir des notifications push plutôt que de devoir rafraîchir constamment une page.

Schéma JSON : Document définissant la structure attendue d’un objet JSON. C’est comme un plan architectural qui indique où doivent se trouver les différentes pièces d’une maison.

Endpoint : Point d’accès spécifique d’une API permettant d’effectuer une action particulière. C’est comme une porte spécifique d’un bâtiment qui mène à un service précis.

Token : Jeton numérique prouvant qu’un utilisateur a le droit d’accéder à un service. C’est comme un ticket de cinéma qui prouve que vous avez payé et pouvez entrer.

Docker : Technologie permettant d’empaqueter une application avec toutes ses dépendances dans un conteneur portable. C’est comme une boîte hermétique contenant tout ce dont votre application a besoin pour fonctionner n’importe où.

Serverless : Modèle de déploiement où le fournisseur cloud gère automatiquement l’infrastructure. C’est comme louer une voiture avec chauffeur plutôt que d’acheter et entretenir votre propre véhicule.

CLI (Command Line Interface) : Interface en ligne de commande permettant d’interagir avec un programme via du texte plutôt que des boutons graphiques. C’est comme piloter un système en tapant des instructions plutôt qu’en cliquant sur des icônes.

Multi-tenant : Architecture où une seule instance d’application sert plusieurs clients (tenants) avec leurs données isolées. C’est comme un immeuble d’appartements où chaque locataire a son espace privé.

IAM (Identity and Access Management) : Système gérant les identités des utilisateurs et leurs permissions d’accès aux ressources. C’est comme un système de badges et de permissions dans un bâtiment sécurisé.

Edge computing : Traitement des données près de leur source plutôt que dans un datacenter distant. C’est comme avoir un mini-ordinateur dans chaque magasin plutôt qu’un seul ordinateur central pour toute la chaîne.

ATS (Applicant Tracking System) : Système de gestion des candidatures utilisé par les départements RH pour suivre les recrutements. C’est comme un système de classement intelligent pour organiser toutes les candidatures reçues.

ERP (Enterprise Resource Planning) : Système intégré gérant les processus métier d’une entreprise (comptabilité, RH, inventaire, etc.). C’est comme le système nerveux central d’une organisation qui connecte tous ses départements.